2023年3月にChatGPT-4.0がリリースされAPI利用も可能になりました。

またChatGPTを追う形で、Google社はGemini(旧:Bard)を、Meta社はLlamaをというようにそれぞれ生成AIをリリース。日本国内でもNECや東京大学松尾研究室などが生成AIを提供している状況です。

SEO支援やコンテンツ制作に身を置く立場として非常に高い関心を持ってこれらの動きを見守ってきており、またWebアプリケーション開発や自然言語処理技術(NLP)はある程度の心得があったため、多くの時間を費やして生成AIを実務に活用できないか、夢中になり模索してきました。

前提として、文章制作には見かけ以上に膨大な工数がかかり、また品質を担保するうえでもチェック項目が多く労力がかかるものです。「では効率化・自動化してみては?」という話になりますが、文章制作というタスクは四則演算のような単純計算でなく、日本語という自然言語を扱うものであるため、これまでプログラム化が難しいという壁がありました。そこでChatGPTが登場してからは、壁を乗り越えてくれるものとして大きな期待を持っていました。

記事制作業務を自動化ないし支援する「業務システム」を開発すべく長い時間をかけて試行錯誤を繰り返した今、結論をお伝えすると、

- 生成AIは、当初思っていたように文章制作タスクのほとんどを自動化して人間のクリエイターにとって代わるものではない

- とはいえある特定のタスクには極めて有効

- 品質・コスト・効率を高めるには「生成/非生成AI・プログラム・クリエイターのベストミックス」を追求すべき

という考えに至りました。

これはSEOコンテンツ制作・Web記事制作の自動化を目指して実験を繰り返したうえでの結論なわけですが、その他の文章制作やチャットボット開発など、幅広い場面にも当てはまる考えではないかと思っています。

また、「AI・プログラム・人間のベストミックス」というのは生成AIの活用に限った話でもなく、かつ決して目新しい考えでもありませんが、「では文章制作を各タスクに細分化した場合に、どの技術をどのタスクに適用すればよいのか」「その場合、クリエイターはどのように関わればよいのか」「AIやプログラムを活用してコストや品質を最大化するための具体的な制作フローは」という、それなりに具体的な道筋まで掘り下げて紹介したいと思います。

「AI」「プログラム」「クリエイター」の特徴

本題である業務システムの話に入る前に、少しおさらいしておきたいことがあります。

記事制作にAIやプログラムを活用する際は、それらの強み・弱みを正確に理解することが不可欠です。特に記事制作では「正確性」「信頼性」といった妥協できない要件が存在しますが、「AI」は確率的に出力する以上、頼りすぎるにはあまりにリスクがあります。またChatGPTのようなLLMが何でもできるわけではなく、コストやスピードという点でもデメリットがあり、このような課題を認識すると最適な設計がしやすくなります。ここでは改めて「AI」「プログラム」「クリエイター」(人間)の三者の違いを振り返りたいと思います。

1.AI

AIとは、あるデータを入力すると確率的にあり得そうな予測を返す「モデル」です。

AIが得意なのは、学習データやパラメータに応じて、「それらしい」回答をして出力くれることです。例えば、膨大な資料のなかから重要度の高い情報をピックアップしてくれたり、内容メモをもとに6〜8割程度の完成度の文章を提示してくれたりといったことは得意です。

弱みは、あらゆる点で出力結果を信頼できないという点です。特に記事制作ではファクトや表記ルールといった細かい点でも正確性・信頼性が求められますが、AIはまだ信頼して任せられるレベルではないので、該当のタスクでは使用しないか、別の方法でカバーする必要があります。また、LLMを使用する場合、自前環境で開発・追加学習するのは簡単ではないので多くのケースではAPI接続することになるかと思いますが、利用コストが高くしかもレスポンスが遅いのはデメリットでしょう。

なおモデルにはさまざまな種類があり、QAタスクのような特定の用途に特化した専門家モデル(「Expert Systems」)や、汎用的な用途で活用できる(少なくともそのように見える)汎用モデルがあります。ChatGPTのような生成AIないしLLMは「汎用モデル」に該当します。「AIの活用」というテーマの議論では、多くの場面でChatGPTのような汎用モデルの活用がフォーカスされがちですが、これは大変なミスリードだと感じていて、特定のタスクにおいては専門家モデルあるいは従来のプログラムの方がコスト面・品質面・効率面でも高いパフォーマンスを得られる傾向があります。これについては後述します。

2.プログラム

プログラミング言語で記述された、ルールベースの処理手順を指します。

得意なのは決められた手順通りに処理を行うことです。これは一見当たり前のようですが文章制作において非常に強力な武器だと思っています。なぜなら文章制作の自動化というと「文章生成」に目が行きがちですが、文章制作は文章作り以外にも資料検索やテキストマイニングといった「リサーチタスク」「分析タスク」や、表記・レギュレーションチェックといった「チェックタスク」にも膨大な工数が発生するものであり、こういった部分を、「漏れなく確実に」「低コストで」「高速に」処理できるのは魅力です。PythonにはNLP関連のライブラリが充実しており、簡単なタスクなら高い精度でクリエイターの支援・代替ができます。また素晴らしいことにTransformer/BertやMeCab、spaCyといった自然言語技術系の主要ライブラリの多くはオープンソースで、ライセンス表示するといった条件のもと無料で利用することが可能です。

弱みは決められていないことは一切できなく、また言語化できないことはプログラム化できない点です。文章制作では「トンマナ」「なぜかは言えないが不適切な表現だと思われるもの」といった暗黙知的な要素が多く、これはプログラム化どころかクリエイターが共有するルールとして定義するのも困難なケースがあります。こういった観点は、クリエイターがカバーする必要があります。

3.クリエイター(人間)

ここで言うクリエイターとは、ディレクターや編集者、ライター、校正者など文章制作に携わる全ての担当者を指します。

クリエイターの大きな強みは、抽象的なタスクをこなせること、高度・複雑な処理手順を実装できる点です。前者については例えば、「記事は落ち着いたテイストで」というレギュレーションがあれば、「具体的にどのような文章が該当するか」という個別の例を指定しなくても適用できます。他にも、NG表現の具体例を示すと、似たような別の表現に遭遇した時に応用できます。後者については、記事制作は高度・複雑な手順もたくさんありますが、模範として記事制作の流れを実演したり口頭で説明したりすれば、真似することが可能です。いずれもAIやプログラムは難しい点で、AIやプログラムの可能性を模索すればするほど、人間の知性レベルの高さを実感しました。

弱みは、「作業手順やルールの漏れ・勘違いなどのリスクは常にある」「人によって認識・スキルの相違が生じる」「物理的に作業時間の限界がある」「習得コストがかかる」「処理速度は機械に勝てない」などが挙げられます。これらの弱みの克服はAIやプログラムが得意とするところでもあり、クリエイターを補う仕組みを整えることが、業務システムの設計の鍵になると思っています。

AI・プログラムの活用方法を設計する際に留意すべきポイント

記事制作にAIやプログラムを活用する際は、それぞれ強み・弱みがある以上、「どのタスクにどのプレイヤーを担当させるのか」を決めるプロセスが重要となります。裏を返すと、この方針が明確であれば、あとは設計・実装すればよいだけなので、導入はスムーズになります。

さて記事制作にAIやプログラムを活用する際は、以下2つのポイントを踏まえて設計するのが重要と考えます。

- 1.タスクを細分化する

- 2.そのタスクを最も得意なプレイヤーに担当させる

記事制作は概ねリサーチ→企画→構成→執筆→校正とシンプルな工程ですが、それぞれの工程を細分化すると、実は複雑なタスクの積み重ねです。自動化・効率化にあたっては、それらをできるだけ細かい粒度まで分解してタスクを並べることが最初のステップとなります。

補足として、仮に業務マニュアルがあるような場合であっても、現職の最も優秀なクリエイターの意見を取り入れるべきです。なぜなら最も優秀なクリエイターは、マニュアルを自分なりに解釈・改良したり、マニュアルに書かれていないことも意識的・無意識的に行ったりして独自の方法を確立しているものであり、その独自手法・タスクを取り入れることで、システムの精度が格段に向上するからです。もちろん、品質基準やレギュレーションを管理する立場である管理者の方針も取り入れる必要があるわけですが、タスクを細分化する際は、最低でも品質管理責任者+最も優秀なクリエイターは議論に加わる必要があるでしょう。

そしてタスクの細分化・洗い出しが済んだ後は、「それぞれのタスクについて、AI、プログラム、クリエイターの誰に担当させるべきか」を考えていきます。この時は、先ほど整理した強み・弱みに沿って、最も適任のプレイヤーを当てはめます。

タスクの具体的な内容と、各プレイヤーの強み・弱みが整理できていればこの選定はスムーズに行くことが多いのですが、ここでも補足として以下を意識すると良いかもしれません。

- クリエイター中心という前提を徹底する

- 相互補完的な仕組みを検討する

まず記事制作はあくまでもクリエイター主体であるという前提があり、AIやプログラムはクリエイターを支援するという考え方を適用することです。なかには「上位サイトの見出しデータを抽出する」「スプレッドシートの見出し・本文情報をドキュメントに転記する」というように明らかに人間よりもAIやプログラムの方が適しており完全に代替させられるタスクもあるのは事実ですが、実際のところ多くのタスクは「人間+AI」「人間+プログラム」というような、相互補完的な仕組みを用いた方が上手く行くようです。

例えば「参考資料のリサーチタスク」のうち、「関連度の高そうな統計・調査資料を50個探す」という子タスクは明らかにプログラムが適しています。Googleは検索APIを提供していますし、NLPのエンベディング・類似度計算を使えばテーマと関連性の高い資料を優先的にピックアップすることが可能です。次に「それぞれの資料の内容を要約・ピックアップする」という子タスクはNLPプログラムあるいはAIが適しているでしょう。クリエイターもできますが、膨大な資料を端的にまとめるのは機械の方が得意です。そして「数多くの候補のなかから、タイトル・要約文などを見て、記事内で参照する資料とその参照内容を選定する」という子タスクはクリエイターしかできないでしょう。なぜならこの子タスクは「メディアのコンセプトや記事のテーマと合致しているか」「文脈上、違和感がなく、主張を裏付ける根拠として説得力があるか」といった抽象的な思考が求められるタスクであり、人間が得意とすることだからです。

このように、各タスクでもさらに細分化することで最適な設計を考えやすくなります。

記事制作業務システムのタスク処理設計

いよいよ本題ですが、AIやプログラムを活用した記事制作業務システムを設計するにあたって、タスクと、担当すべきプレイヤーを以下の表にまとめました。

| 親タスク | 子タスク | 生成AI | AI | プログラム | クリエイター | 解説 |

| リサーチ | 外部資料・データの調査 | ◯ | ◎ | ◎ | ◯ | 適切なWebサイト・ページを探し当てるうえでは、自然言語処理系AIを搭載したプログラムが極めて有効。 情報のピックアップやそれを踏まえた回答文の生成は生成AIに任せることが可能。 ファイルの候補や要約文が揃った段階でクリエイターが使えるものを取捨選択するのが効率的と思われる。 |

| 社内資料・データの調査 | ◯ | ◎ | ◎ | ◯ | 同上だが、社内にある該当のファイルが、業務システムによってアクセス・検索可能な状態である必要がある。 | |

| 上位ページの調査 | △ | ◎ | ◎ | ◯ | 検索上位サイトの見出し・本文情報を抽出したり、重要キーワードや重要テーマをマイニングしたりするのは自然言語処理系AIやプログラムが極めて得意。処理が速いうえ確実性が高く、コストも生成AIに比べて安い。 コンセプト面での分析や細かい内容の抽出はクリエイターが得意。 生成AIは必ずしも要約が得意でなく(重要情報がピックアップされないなど)また大量ページの分析にはコストも処理時間もかかる。 | |

| 分析・企画 | 上位ページのグルーピング・ラベル付け | △ | ◎ | ◎ | ◎ | 膨大な見出し・本文情報をグルーピングするには自然言語処理のエンべディング・クラスター分析が有効。 最終的にはクリエイターが判断するが、その前段階として活用したい。 生成AIはあまり有効な回答が得られず、また勝手に一部の入力を無視することがある点やフォーマットを徹底できない点が難。 |

| 重要KW・コンテンツの抽出 | △ | ◎ | ◎ | ◯ | キーワード分解や文章の重要度計算をするにあたっては自然言語処理に最適なライブラリが揃っており、クリエイターを支援する武器になる。 | |

| 記事分量の検討 | △ | △ | ◎ | ◯ | アルゴリズムを組むことで、上位サイトや参考資料情報をもとに、プログラム的に高い精度で計算できる。 | |

| 構成・アウトライン | タイトル決定 | △ | × | ◯ | ◎ | 生成AIはテイスト・コンセプトとはかけ離れたものを出力することも多く、SEO記事で重要な、メインキーワードの含有を無視することもありあまり頼りにくい。 クリエイターがメインとなるが、SEO観点で重要キーワードの含有チェックや他記事とのコピーチェックという点ではプログラムが活用できる。 |

| 各h見出しの作成 | ◯ | × | × | ◎ | 見出しはテーマ・メディアコンセプトや並び順、印象など検討要素が多く暗黙知も多いため依然クリエイターならではのタスクと思われる。ただし生成AIに原案として候補を出してもらうことは可能。 | |

| 各セクションごとの内容・文字数決定 | △ | × | ◯ | ◎ | 同上で、生成AIやプログラムが原案を出すことは可能だが、熟練のクリエイターが最終判断する必要がある | |

| 執筆 | 本文の作成 | ◎ | × | × | ◎ | 生成AIに記事のターゲット読者やコンセプトに加え見出しをインプットすれば6〜8割程度の完成度の文章は出力してくれる印象。生成AIはもともとWeb記事を多く学習しておりSEO記事と相性は高い。 「同じく生成AIで制作された記事と重複してしまう」「入力した内容を勝手にカットしてしまう」といったリスク・難点はあるが、独自の執筆内容を入力したりプロンプトを工夫したりすることで回避可能であった。 生成AIに草稿を出力させクリエイターが仕上げるという方法でも工数は半分程度に抑えられる印象。 |

| 校正 | ファクトチェック | × | △ | ◯ | ◎ | 最終的にはクリエイターの目で確認する必要があるものの、ファクトの根拠になりそうな文章を検索ないし資料検索して候補を提示するところまではプログラムとQAタスク特化のAIモデルが活用できそう。生成AIでは信頼度が低いので以ての外。 |

| 文章の文法・誤字脱字チェック | △ | △ | ◯ | ◯ | クリエイターは膨大な文章をチェックする以上漏れがあるが、明文化できるルール・誤字脱字であればプログラムで判断可能。 生成AIも活用できる可能性があるが、正しい文章まで誤っていると抽出してしまいその判断に余計なリソースが割かれるなどのデメリットも。またそもそも生成AIはレスポンスが遅くコストが高いので、安価なプログラムがクリエイターを支えるのが効率的。 | |

| トンマナ・テイストチェック | ? | × | △ | ◎ | 抽象思考が求められる部分で、機械に代替させるのは難しい印象。生成AIのパフォーマンスも、出力にブレがありすぎて現時点では未知数。 ただしNGワードのような明文ルールの場合は機械でチェック可能。 | |

| 表記ルール・レギュレーションチェック | × | × | ◎ | ◯ | クリエイターが最終的に判断。 表記ルールのような機械的なチェックはプログラムが最も得意で、システムに組み込むべき。 生成AIはテストしたものの、どうしても表記ルールまでは守ってくれなかった。 | |

| コピーチェック | ? | ? | ◎ | △ | 膨大なコンテンツをクリエイターが逐一チェックするのは困難。 単純作業であり、プログラムが得意。巧妙な改変があってもチェック可能。 あえてコスト・レスポンスで劣る生成AIに頼るまでもないと思われる。 |

設計した所感としては、業務システムがあったとて万能ではなく、クリエイターの役割は依然大きいという点です。とはいえ単純タスクはAI・プログラムが代替できるのも事実で、クリエイターはより抽象タスクに集中するようになることから、クリエイターには抽象思考と習熟度が求められます。

また巷では生成AIが注目されがちで、かく言う私も当初は生成AIがタスクを代替してくれるものと期待してさまざまなテストを行ったわけですが、ぜひ生成AIを使いたいという結論に至ったのは執筆タスク(のうち草稿作成)のみで、実際には非生成AIやNLP技術、プログラムのパフォーマンスの高さに気がつく結果でした。表でも、AIやプログラムには「◯」が多く付いています。

これは強調したい点なので少し掘り下げます。そもそもChatGPTをはじめとする生成AI(LLM)はTransformerなどのNLP技術をベースに事前学習させたモデルなわけですが、「素」のNLP技術を使えばChatGPTのように事前学習されていないことから用途に最適なカスタマイズができるうえ、十分な性能を発揮できる場面が多くあります。例えば「この文章はテーマと関連しているか?」と判別する際、生成AIに尋ねてももちろん適切な回答が得られますが、PythonのNLPライブラリでエンベディングのうえ類似度計算をすれば事足りるうえ処理速度も速く外部コストもかかりません。この結果は意外でしたが、コスト・処理速度・品質というパフォーマンスを求めるうえでは極めて重要な気づきでした。この気づきを得てからは、生成AIは特定タスクでは取り入れるものの、全体的にはNLP技術を軸に業務システムを設計するのが最適と確信し、実装の方向性も定まりました。なおこの結論はあくまでも「SEO記事制作でかつ私の業務プロセス」という文脈での考えです。今後状況が変化したり、文脈が違ったりする場合は、当然ながら別の最適解があるはずです。

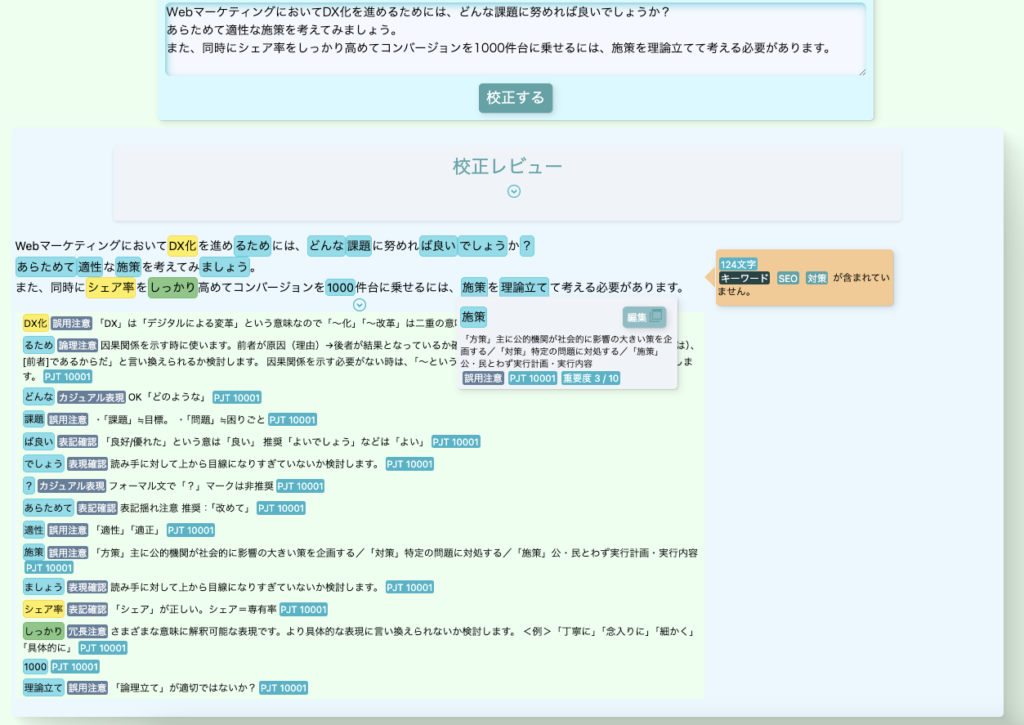

なおこのシステムが完全に実現すれば、記事制作の工数は半分程度に、品質は定量化が難しいのですが体感で30%程度向上すると考えています。クリエイターの人数不足解消や品質管理の効率などさまざま貢献するものとして期待しています。2024年4月現在、開発中で、「Queries校正ツール」のように部分的に完成しているツールやコンポーネントはありますが、お出しできるものは順次公開したいと思っています。

非AIのルールベースのみだが表記チェックには十分。

業務システムを設計するうえでは各分野の専門家が協力すべき

記事制作の業務システムを設計するにあたって繰り返し強調しておきたいのは、「生成AIのような技術が人間を代替するのかどうか」というバイナリー(二元論)ではなく、「クリエイターを支援するために、生成AIやプログラムができることは何で、業務システムにどのように組み込むか」という観点だと思います。

そのためには業務プロセスを完全に知り尽くしたクリエイターによる丁寧なタスクの棚卸しが必要ですし、文章を扱う以上はNLP技術や生成AIといった各種技術について幅広く知っており強み・弱みも正確に理解しているNLP/AIエンジニアの知見、さらにはアイデアを形にするためのアプリケーション開発エンジニアの三者の強力が不可欠です。

余談ですが私は個人的に業務システムを作ってみるのにあたって、SEO記事制作経験が長く、技術面では幸いにもわずかながらSIerでの勤務経験があり、また文章を扱う仕事であるためNLPにはかねてより注目しており予備知識がある状態でのスタートでした。

そのため2023年から次々リリースされる生成AI関連技術の情報収集・理解や実装に向けたアイデア固めはスムーズではありましたが、各AIのパフォーマンステストや実装となると物理的な工数が必要で、2024年4月時点、個人で開発するのは不可能ではないものの、仲間がいると心強い、とも感じています。例えば記事を生成AIに書いてもらう際に、ChatGPTとVertex AIの比較やプロンプト調整を行う必要がありますが、これはライターやLLMに詳しい人がチームとなって複数人でテスト・検討する方が明らかに効率的です。もしチームで取り組める環境なら、それは大きな武器だと思います。

まとめ

ChatGPT-4.0が登場した時はSEO記事制作業務を自動化ないし効率化してくれるものと大変期待しましたが、現実は良い点もあれば難点もありました。むしろ必ず手順通りに動くプログラムの力や生成AIの基盤であるNLP技術の魅力を再認識し、記事制作ではまずそれらの技術を使って改善するのが先であるべきと考えています。

現時点での結論をまとめると以下の通りです。

- 生成AIは、特定のタスクには有効だがコスト・処理速度・精度の点では必ずしも信頼できないので原案作成に適任か

- 生成AIよりも従来のNLP技術やルールベースのプログラムは大いに活用の余地がある

- 記事の品質・コスト・制作効率を高めるには「生成/非生成AI・プログラム・クリエイターのベストミックス」を追求すべき

方向性が定まって業務システムを開発中ですが、もしお役に立てることでお声掛けいただけるからにはできるだけお力になりたいと考えています。ご興味がある方は問い合わせフォームからご連絡ください。